Inhaltsverzeichnis:

1. Was ist Ultraschall?

2. Entstehung

3. Vorkommen in der Natur

4. Menschengemachter Ultraschall

5. Ultraschall hörbar machen

6. Aliasing-Effekt

7. Nichtlineare Verzerrungen

8. Demodulation

9. Raudive-Diode

10. Demodulation durch Reflexion (Schwebung)

11. Tonbandstimmen und Ultraschall

12. Quellen

1. Was ist Ultraschall?

In diesem Beitrag soll das Thema Ultraschall in Kombination mit der Entstehung von Tonbandstimmen behandelt werden. Dadurch soll eine praxisnahe Theorie veranschaulicht werden, die möglicherweise Aufschluss darüber liefern könnte, woher die aufgezeichneten Stimmen aus dem Jenseits kommen.

Bei diesem Thema denken wohl die wenigsten an das Paranormale, sondern viel eher an einen Arztbesuch oder Fledermäuse, denn Ultraschall bezeichnet Schallwellen mit Frequenzen oberhalb des menschlichen Hörbereichs, also ab 20 kHz bis zu mehreren Gigahertz. Diese Wellen sind daher für das menschliche Ohr nicht hörbar, da unser Hörbereich zwischen 20 Hz und etwa 20 kHz liegt. Frequenzen unterhalb von 20 Hz nennt man Infraschall [3] [6].

Wie und warum hört man Schall? Die sogenannte Cochlea (Schnecke) ist ein Teil des Innenohrs, das die Schallwellen in Nervenimpulse umwandelt. Dies geschieht über Haar-Sinneszellen, die auf diesen Frequenzbereich ausgelegt sind bzw. ist das menschliche Gehör auf Sprach- und Alltagsgeräusche optimiert, was dem Frequenzbereich zwischen 20 Hz und 4 kHz entspricht. Am empfindlichsten reagiert das Ohr allerdings auf Frequenzen zwischen 2 und 5 kHz. Bezogen auf die hohen Frequenzen können Kinder in jungen Jahren teilweise Frequenzen bis zu 30 kHz hören. Das liegt daran, dass die Haarzellen in der Cochlea bei Kindern empfindlicher sind, was sich mit zunehmendem Alter, durch die Degeneration (Alterung/Verfall) dieser Haarzellen, verändert [8].

Es gibt Hinweise darauf, dass das Gehirn in tiefen Strukturen, wie dem Hirnstamm, auf Frequenzen oberhalb von 22 kHz reagieren kann und auf neuronaler Ebene registriert (Hypersonic Effect). Hier kann man jedoch nicht von einer bewussten Wahrnehmung sprechen [9].

Während hörbarer Schall für die Kommunikation und Wahrnehmung im Alltag entscheidend ist, wird Ultraschall wegen seiner hohen Frequenz für spezialisierte Anwendungen wie in der Medizin oder Materialprüfung genutzt. Im Vergleich zu hörbarem Schall breitet sich Ultraschall in der Luft, aufgrund seiner höheren Frequenzen, weniger weit aus und wird stärker gedämpft. Dies bedeutet, dass er schneller als hörbarer Schall an Intensität verliert [1] [6] [20].

2. Entstehung

Im Allgemeinen sind Schallwellen mechanische Schwingungen, die sich durch ein Medium, wie z.B. Luft oder Wasser, ausbreiten können. Sie entstehen, wenn ein Objekt vibriert oder schwingt und diese Bewegung auf die Teilchen des umgebenden Mediums überträgt. Schallwellen bestehen aus abwechselnden Verdichtungen und Verdünnungen der Moleküle des Mediums, die sich wellenförmig ausbreiten.

Daher entsteht Ultraschall auch durch z.B. mechanische Schwingungen eines Objekts, (Medium, Membran), wobei diese Schwingungen mit einer Frequenz über 20 kHz erfolgen müssen. Weitere Möglichkeiten sind die piezoelektrische oder magnetostriktive Erzeugung. Piezoelektrische Materialien wie Quarzkristalle verändern ihre Form, wenn an ihnen eine Spannung angelegt wird. Durch schnelle Wechsel der angelegten Spannung (Wechselspannung) wird das Material in Vibration versetzt, und es entstehen Ultraschallwellen. Diese Methode wird in den meisten technischen Anwendungen, wie z.B. in Ultraschallreinigern oder medizinischen Ultraschallgeräten, genutzt. Bestimmte Materialien wie Nickel verformen sich unter einem Magnetfeld. Wenn das Magnetfeld regelmäßig gewechselt wird, entstehen mechanische Vibrationen, die Ultraschall erzeugen [3].

Es ist auch mithilfe von elektrischen Schaltungen wie dem NE555-Timer oder anderen Oszillatoren möglich, hochfrequente Schwingungen zu erzeugen. Wird diese Schwingung an einen Lautsprecher oder einen piezoelektrischen Wandler angelegt, entsteht Ultraschall [4].

3. Vorkommen in der Natur

Fledermäuse nutzen Ultraschall zur Echoortung. Sie erzeugen, durch schnelle Kontraktionen spezieller Muskeln im Kehlkopf, Schallwellen mit Frequenzen zwischen 20 und 100 kHz. Die ausgesendeten Schallwellen treffen auf Hindernisse oder Beutetiere und werden reflektiert. Das Echo wird von den hochentwickelten Ohren der Fledermaus wahrgenommen, wodurch sie die Größe, Form und Entfernung von Objekten bestimmen kann. Delfine oder Zahnwale erzeugen ebenfalls und durch spezielle Nasengänge Ultraschall. Die reflektierten Schallwellen werden durch Unterkieferknochen empfangen und zum Innenohr geleitet, wodurch die Tiere im trüben Gewässer oder bei Dunkelheit “sehen” können. Einige Nagetiere wie Mäuse oder Ratten verwenden Ultraschallrufe zur Kommunikation. Diese Laute werden durch den Kehlkopf erzeugt und spielen eine Rolle bei der Partnerfindung oder der Warnung vor Gefahren. Bestimmte Insekten, wie Nachtfalter, haben sich darauf spezialisiert, Ultraschall auszusenden oder zu hören. Sie nutzen dies zur Kommunikation oder um Raubtiere wie Fledermäuse zu meiden.

Aber nicht nur Tiere erzeugen in der Natur Ultraschall – Bewegungen der Erdkruste, wie bei Erdbeben oder einem Vulkanausbruch, können Ultraschallwellen erzeugen, die über weite Distanzen durch das Erdreich geleitet werden. Wasserfälle oder die Bewegung von Wellen können genauso Ultraschallwellen erzeugen [1] [2].

4. Menschengemachter Ultraschall

In der Medizin verwendet man für sogenannte bildgebende Verfahren (Untersuchung von Weichteilen und Organen) Ultraschall, was auch als Sonografie bekannt ist. Der Ultraschallkopf (Transducer) sendet hochfrequente Schallwellen (zwischen 1 und 20 MHz) in den Körper, die an Gewebe- und Organ-Grenzflächen reflektiert werden. Der Transducer ist auch in der Lage, die reflektierten Wellen zu empfangen, woraus das Ultraschallgerät ein Bild berechnet [1].

Ultraschall wird auch zur Schmerzlinderung und zur Unterstützung der Heilung bei Muskel- und Gelenkproblemen eingesetzt. Der sogenannte „hochintensive fokussierte Ultraschall“ (HIFU) ist ein Verfahren, um Tumore zu behandeln. Dabei werden Ultraschallwellen auf einen kleinen Punkt im Körper fokussiert, wodurch Wärme erzeugt und so das Tumorgewebe zerstört wird [5].

Neben den bekannten Ultraschallreinigungsgeräten (20 – 40 kHz) werden Ultraschallwellen auch dazu verwendet um Risse, Inhomogenitäten oder Materialfehler in Werkstoffen zu detektieren, ohne das Material zu zerstören. Ebenso kann Ultraschall zum Schweißen oder zum Zerkleinern von Partikeln verwendet werden. Ultraschall kennt man aber auch aus dem Bereich der Kommunikation oder Sensorik und wird in der Automobilindustrie gerne zur Entfernungsmessung und Hinderniserkennung verwendet. In der Schifffahrt und U-Boot-Technologie wird Ultraschall zur Bestimmung von Wassertiefen oder zur Ortung von Objekten unter Wasser genutzt (wie bei Fledermäusen in der Luft). Ein Sonarsystem sendet Ultraschallwellen aus, die von Objekten reflektiert werden. Anhand der Laufzeit und der Stärke des reflektierten Signals können Objekte detektiert und kartiert werden [1] [2].

5. Ultraschall hörbar machen

Auch wenn Ultraschall für das menschliche Ohr nicht direkt hörbar ist, gibt es dennoch verschiedene physikalische und technische Phänomene, die es ermöglichen, Ultraschallfrequenzen in hörbare Töne zu transformieren. Hierbei spricht man von der sogenannten Demodulation.

Es gibt selbstverständlich auch speziell konzipierte Geräte wie Fledermausdetektoren, die mit der Heterodyning-Technologie arbeiten, bei der die Ultraschallfrequenzen mit einer niedrigeren Oszillatorfrequenz gemischt und dadurch hörbar werden. Diese Mischung erzeugt eine Frequenzverschiebung. Das Ganze lässt sich auch über ein Ultraschallmikrofon und einen Computer realisieren [10]. Allgemein spricht man bei dem physikalischen Phänomen, wenn durch die nichtlineare Wechselwirkung von zwei oder mehr Signalen neue Frequenzen entstehen, von Intermodulation. Nichtlinear heißt hier, dass die Beziehung in einem System, zwischen Eingangs- und Ausgangssignal, nicht proportional ist [11].

In diesem Beitrag sollen physikalische Effekte erklärt werden, die ohne spezielle Technik ebenfalls dafür sorgen können, dass nicht hörbarer Ultraschall in das für unser Ohr hörbare, akustische Spektrum transformiert wird. Die hier thematisierten Effekte nennen sich Aliasing-Effekt, nichtlineare Verzerrung/Intermodulation wie auch die Demodulation durch Reflexion.

6. Aliasing-Effekt

Dieser Effekt tritt auf, wenn ein Signal mit einer zu niedrigen Abtastrate (Samplerate) digitalisiert wird. Das führt dazu, dass hohe Frequenzen des Signals fälschlicherweise als niedrigere Frequenzen erscheinen. Der Aliasing-Effekt kann dazu führen, dass ein Signal nicht korrekt wiedergegeben oder interpretiert wird, oder konkret, dass Ultraschallsignale in den hörbaren Bereich verschoben werden [12].

Gemäß dem Nyquist-Shannon-Abtasttheorem muss die Abtastrate, um ein Signal korrekt abbilden zu können, mindestens doppelt so hoch sein wie die höchste zu erfassende Frequenz des Signals.

Nicht umsonst wurde im Jahr 1980 der Audio-CD-Standard offiziell festgelegt. Dieser besagt, dass die Aufnahme, neben einer vertikalen Auflösung von 16 Bit, eine Abtastrate von 44,1 kHz (44.100 Abtastungen pro Sekunde) haben muss, um das menschliche Hörspektrum, das von etwa 20 Hz bis 20 kHz reicht, optimal abzudecken. Um jedoch Verzerrungen und den Verlust von Informationen an der Grenze des Hörspektrums zu vermeiden (Sicherheitsmarge), wurden nicht 40 kHz als Abtastrate verwendet, sondern 44,1 kHz. Audiosignale bis zu einer Frequenz von 22,05 kHz (Nyquist-Frequenz) können so korrekt digitalisiert werden [13] [14].

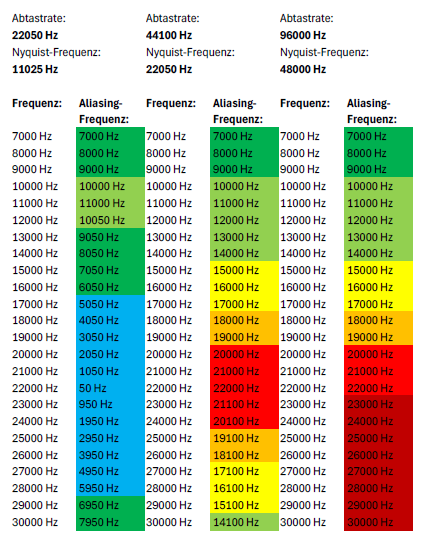

Dass es exakt 44,1 kHz geworden sind, liegt daran, dass die frühen digitalen PCM-Recorder (Pulse Code Modulation), zum Speichern digitaler Audio-Dateien, eine Video-Aufnahmetechnologie nutzten. Der also dahintersteckende, technische Grund liegt an einer NTSC (30 fps) / PAL (25 fps) Videosignal-Bildzeilenanpassung. Bei PAL gibt es je Bild 1.764 Samples, was bei 25 fps eine Samplerate von 44,1 kHz ergibt. So konnten Audiosignale problemlos auf Videobändern aufgezeichnet werden [15]. Beachtet man diese Vorgabe jedoch nicht, kommt es zu Aliasing (Alias, “falscher Name”), bei dem die Frequenzen oberhalb der Nyquist-Frequenz (halbe Abtastrate) als niedrigere Frequenzen erscheinen (siehe Abbildung 1) [12] [20].

Abbildung 1:

Frequenzveränderung durch unterschiedliche Abtastraten (eigene Abbildung von Tim Timsen).

Vor den bekannten 44,1 kHz gab es auch geringere Abtastraten wie 32 kHz, 22,05 kHz (22 kHz) oder auch 11,025 kHz (11 kHz); da sich aber die digitale Audiotechnologie weiterentwickelt hat, gehören Abtastraten von 48 kHz, 96 kHz oder auch 192 kHz zu mittlerweile gängigen Auswahlmöglichkeiten. Durch die hochauflösenden Videoproduktionen (DVD, HDTV) erhöhte man, in Anlehnung an eine in den 1970er Jahren bereits weitverbreitete, digitale 8 kHz Abtastrate im Telefonnetz, die Abtastrate in professionellen Audio- und Videoproduktionen auf 48 kHz, was auch zur Standard-Abtastrate wurde.

Die Abtastraten von 96 kHz wie auch 192 kHz wurden später in der Musikproduktion und in hochwertigen Audioanwendungen, die speziell darauf abzielen, die höchste Klangtreue und Qualität zu bieten, eingeführt. Da ein akustisches Signal oder allgemein ein analoges Signal theoretisch unendlich viele Informationen besitzt, bedarf es auch, für eine verlustfreie Digitalisierung, eine höchstmögliche Abtastrate. Ob eine Verzerrung durch Aliasing vorliegt und welche die erzeugte Aliasing-Frequenz ist, lässt sich sehr leicht berechnen.

Beispiele:

Abtastrate: 44,1 kHz

Nyquist-Frequenz: 22,05 kHz (halbe Abtastrate)

- Eingangsfrequenz: 22 kHz

Da 22 kHz noch unterhalb der Nyquist-Frequenz liegt, wird das Signal korrekt mit 22 kHz aufgenommen.

- Eingangsfrequenz: 28 kHz

28 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

44,1 kHz − 28 kHz = 16,1 kHz

Das 28 kHz Signal wird bei einer Abtastrate von 44,1 kHz als 16,1 kHz Signal aufgezeichnet.

- Eingangsfrequenz: 34 kHz

34 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

44,1 kHz − 34 kHz = 10,1 kHz

Das 34 kHz Signal wird bei einer Abtastrate von 44,1 kHz als 16,1 kHz Signal aufgezeichnet.

- Eingangsfrequenz: 45 kHz

45 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

45 kHz – 44,1 kHz = 0,9 kHz (vertauscht, da Absolutwert relevant ist)

Das 45 kHz Signal wird bei einer Abtastrate von 44,1 kHz als 900 Hz Signal aufgezeichnet.

Abtastrate: 48 kHz

Nyquist-Frequenz: 24 kHz (halbe Abtastrate)

- Eingangsfrequenz: 22 kHz

Da 22 kHz noch unterhalb der Nyquist-Frequenz liegt, wird das Signal korrekt mit 22 kHz aufgenommen.

- Eingangsfrequenz: 28 kHz

28 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

48 kHz − 28 kHz = 20 kHz

Das 28 kHz Signal wird bei einer Abtastrate von 48 kHz als 20 kHz Signal aufgezeichnet.

- Eingangsfrequenz: 34 kHz

34 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

48 kHz − 34 kHz = 14 kHz

Das 34 kHz Signal wird bei einer Abtastrate von 48 kHz als 14 kHz Signal aufgezeichnet.

- Eingangsfrequenz: 45 kHz

45 kHz ist über der Nyquist-Frequenz, es tritt Aliasing auf.

48 kHz – 45 kHz = 3 kHz

Das 45 kHz Signal wird bei einer Abtastrate von 48 kHz als 3 kHz Signal aufgezeichnet.

Diese Beispiele zeigen deutlich, wie wichtig die Wahl der richtigen Abtastrate ist, um Aliasing zu vermeiden bzw. um Ultraschall durch diesen Effekt in den hörbaren Bereich zu verschieben [16].

7. Nichtlineare Verzerrungen

Eine nichtlineare Verzerrung tritt auf, wenn in einem System die Beziehung zwischen dem Eingangs- und dem Ausgangssignal nicht mehr proportional ist. Dies führt dazu, dass sogenannte Obertöne (höhere Frequenzen, zusätzlich zur Grundfrequenz) oder allgemein neue Frequenzen (harmonische, nicht harmonische bzw. Intermodulationsprodukte) entstehen, die im ursprünglichen Signal nicht vorhanden waren. Diese Verzerrungen können dazu führen, dass z.B. Ultraschallsignale in den hörbaren Bereich verschoben werden.

Doch was genau bedeutet das alles?

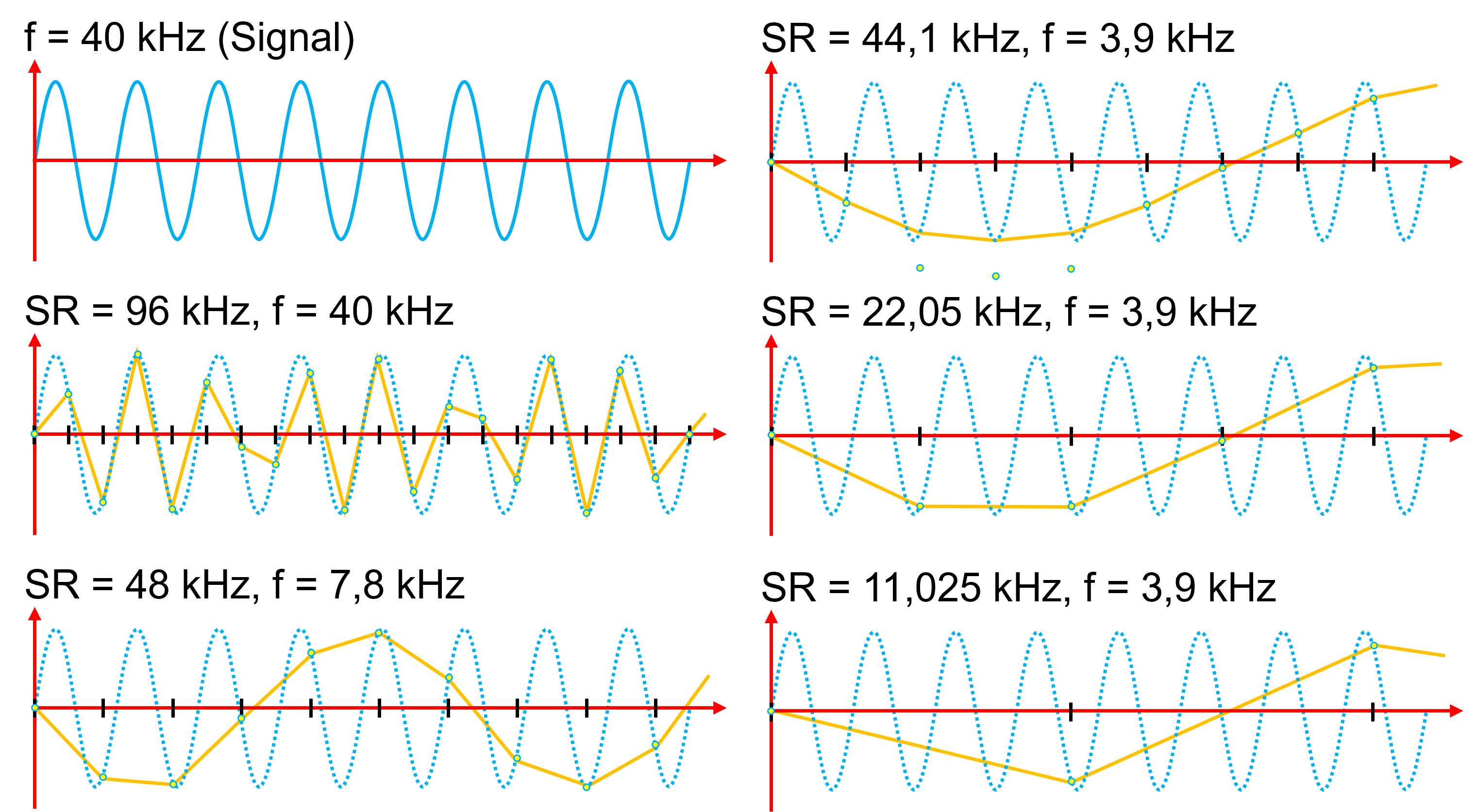

Ein nichtlinearer oder nichtproportionaler Zusammenhang zwischen Eingang und Ausgang bedeutet, dass sich das Eingangssignal beispielsweise verdoppelt, das Ausgangssignal jedoch nicht. Dadurch, dass die eigentliche Beziehung zwischen Ein- und Ausgang nicht gegeben ist, werden Signale verzerrt. Geben wir in unser System ein Sinussignal (periodische Wellenform) erhält man, wie in Abbildung 2 zu sehen, ein abgeschnittenes Ausgangssignal, welches in seiner Form nicht mehr dem am Eingang entspricht. Das neue Signal besteht aus einer Mischung unterschiedlicher Sinus- und Kosinussignalen mit unterschiedlichen Frequenzen (zusätzliche Obertöne), die in der Summe das neue Ausgangssignal erzeugen. Obertöne sind dabei das Vielfache der Grundfrequenz. In der Mathematik gibt es die sogenannte Fourier-Analyse, bei der durch die Summe von Sinus- und Kosinuswellen mit unterschiedlichen Frequenzen verzerrte, nichtlineare Systeme dargestellt werden können. Als Maß für nichtlineare Verzerrungen dient der Klirrfaktor und wird in % direkt, oder umgerechnet als Klirrdämpfung in dB angegeben [17] [18].

Abbildung 2:

Signal- bzw. Frequenzveränderung durch nichtlineare Verzerrung (eigene Abbildung von Tim Timsen).

Aufgrund der erwähnten Nichtlinearität zwischen dem Eingang und dem Ausgang kommt es bei dieser Art von System zu Intermodulation. Anders als bei linearen Systemen, bei dem das Superpositionsprinzip (Amplitudenaddition) dafür sorgt, dass die Beziehung zwischen Eingang und Ausgang direkt und proportional ist, ermöglicht ein nichtlineares System, dass verschiedene Frequenzen miteinander interagieren und so neue Frequenzen entstehen können. Die durch Intermodulation entstandenen Differenzfrequenzen sind das Ergebnis der Addition und/oder Subtraktion der Grundfrequenzen. Interagieren beispielsweise die Frequenzen 28 kHz und 16 kHz, sind, dank der Nichtlinearität, die daraus resultierenden Intermodulationen 44 kHz (Addition) und 12 kHz (Subtraktion) [19]. Aufgrund der physikalischen bzw. elektrischen Eigenschaften mancher Bauteile (Halbleiterbauelemente wie Dioden und Transistoren), entsteht eine Nichtlinearität, das bedeutet, die Materialien reagieren unter bestimmten Umständen (Spannung oder Temperaturveränderung) anders. Eine Diode etwa leitet erst dann, wenn eine bestimmte Schwellspannung überschritten wurde und das nur in eine Richtung; oder manche Verstärker gehen ab einem bestimmten Punkt in die Sättigung (maximaler Ausgangswert erreicht), wodurch das Ausgangssignal abgeschnitten oder verzerrt wird. Bei Transistorschaltungen (Verstärker) existieren schon sehr lange Stabilisierungsschaltungen, die dafür sorgen, dass der Arbeitspunkt auch bei einer Temperaturveränderung stabil bleibt. Ältere Geräte sind möglicherweise hiervon nicht betroffen, was sie anfällig für Signalverzerrungen macht.

Auch bei Magnetbändern (Kassetten) kann es zu einer Sättigung kommen (maximale Magnetisierungsfähigkeit erreicht), wenn z.B. der Eingangspegel zu hoch ist, wodurch das Magnetband nicht mehr in der Lage ist, die vollen Variationen des Magnetfeldes (Tonkopf) wahrzunehmen bzw. abzubilden. Dies führt zum sogenannten Clipping und damit zu nichtlinearen Verzerrungen. Da das Verhalten eines magnetischen Materials (z.B. Magnetband), in Abhängigkeit von einem externen Magnetfeld, keinen linearen Verlauf aufweist (Hysteresekurve), bedarf es nicht einmal eines übersteuertes Eingangssignales, um möglicherweise eine nichtlineare Verzerrung zu erzeugen. Ebenfalls kann es bei manchen Kassettenrekordern durch eine Vormagnetisierung (hochfrequente Wechselspannung) passieren, dass in Kombination mit bestimmten Frequenzen das Material eine Sättigung erreicht. Aber auch Temperaturveränderungen führen hier dazu, dass sich elektrische Bauteileigenschaften bzw. sich die Magnetbänder selbst verändern, wodurch ein nichtlinearer Effekt auftritt [20].

8. Demodulation

Allgemein können wir beim Hörbarmachen von beispielsweise Ultraschallsignalen, etwa durch den beschriebenen Aliasing-Effekt oder durch eine nichtlineare Verzerrung, von Demodulation sprechen. In der Kommunikations- bzw. Rundfunktechnik (Radio, AM/FM) wird Demodulation verwendet, um ein Nutzsignal (z.B. Audioinhalt) aus einem hochfrequenten Trägersignal zu extrahieren.

Ein Prinzip der Demodulation (Heterodyn-/Mischdemodulation) basiert auf der Interferenz (Wechselwirkung beim Überlagern von mindestens zwei Wellen) zwischen dem Trägersignal und einer lokalen Oszillatorfrequenz. Durch die Mischung der beiden Frequenzen wird eine Zwischenfrequenz erzeugt, die das modulierte Nutzsignal in einen Bereich verschiebt, in dem es leichter extrahiert werden kann [20] [21] [22] [24].

9. Raudive-Diode

Eine Demodulation durch Audiokomponenten (Transistoren, Dioden), wie unter „Nichtlineare Verzerrungen“ beschrieben, kennt man aus dem Bereich der instrumentellen Transkommunikation (ITK) und dem dort bekannten „Raudive-Diode“-Experiment.

Dabei wird eine einfache elektrische Schaltung verwendet, die mittels Diode und deren Eigenschaft der Nichtlinearität, hochfrequente und amplitudenmodulierte Frequenzen hörbar machen kann (AM-Demodulation). In den zufällig umgebenen AM-Signalen, die vielleicht ein Produkt aus dem Jenseits oder einer jenseitigen Welt sein könnten, sollen so Stimmen extrahiert werden.

Wie bereits beschrieben, weist die Diode eine Nichtlinearität auf, da sie den Strom nur in eine Richtung leitet und dies erst ab einer bestimmten Schwellspannung zulässt. Des Weiteren weist sie ein temperaturabhängiges Verhalten auf. So erhält man ein gleichgerichtetes Signal, bei dem nur der positive oder negative Teil der Schwingung durchgelassen wird. Um das Audiosignal bestmöglich von dem ursprünglichen Trägersignal zu lösen, wird das gleichgerichtete Signal an einem Kondensator bzw. Widerstand (RC-Kombination) geglättet. So werden AM-Signal sehr einfach hörbar gemacht bzw. erhält man durch dieses Verfahren, aus den zufälligen AM-Signalen in der Umgebung, als Nebenprodukt der Nichtlinearität der Diode die sehr leisen, jenseitigen Stimmen [23] [24].

10. Demodulation durch Reflexion (Schwebung)

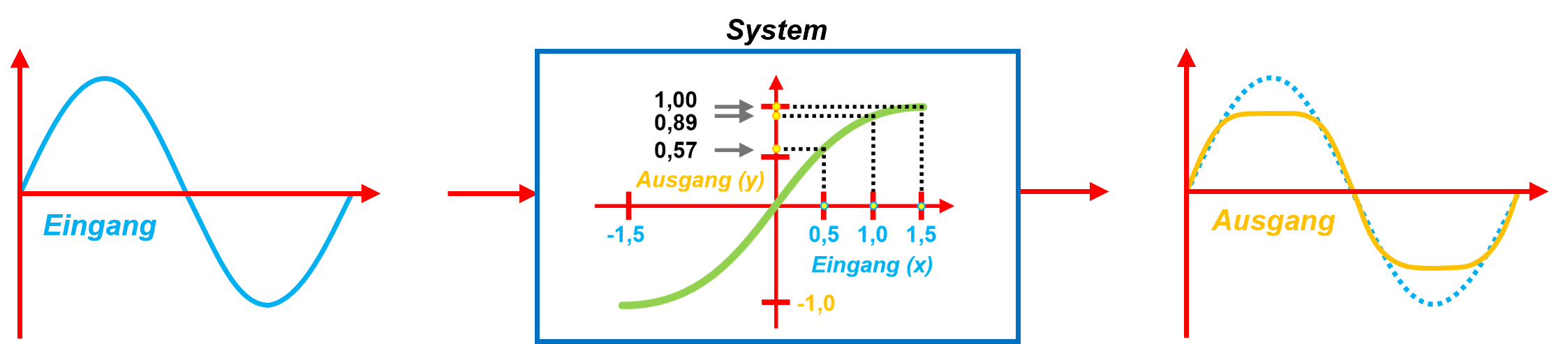

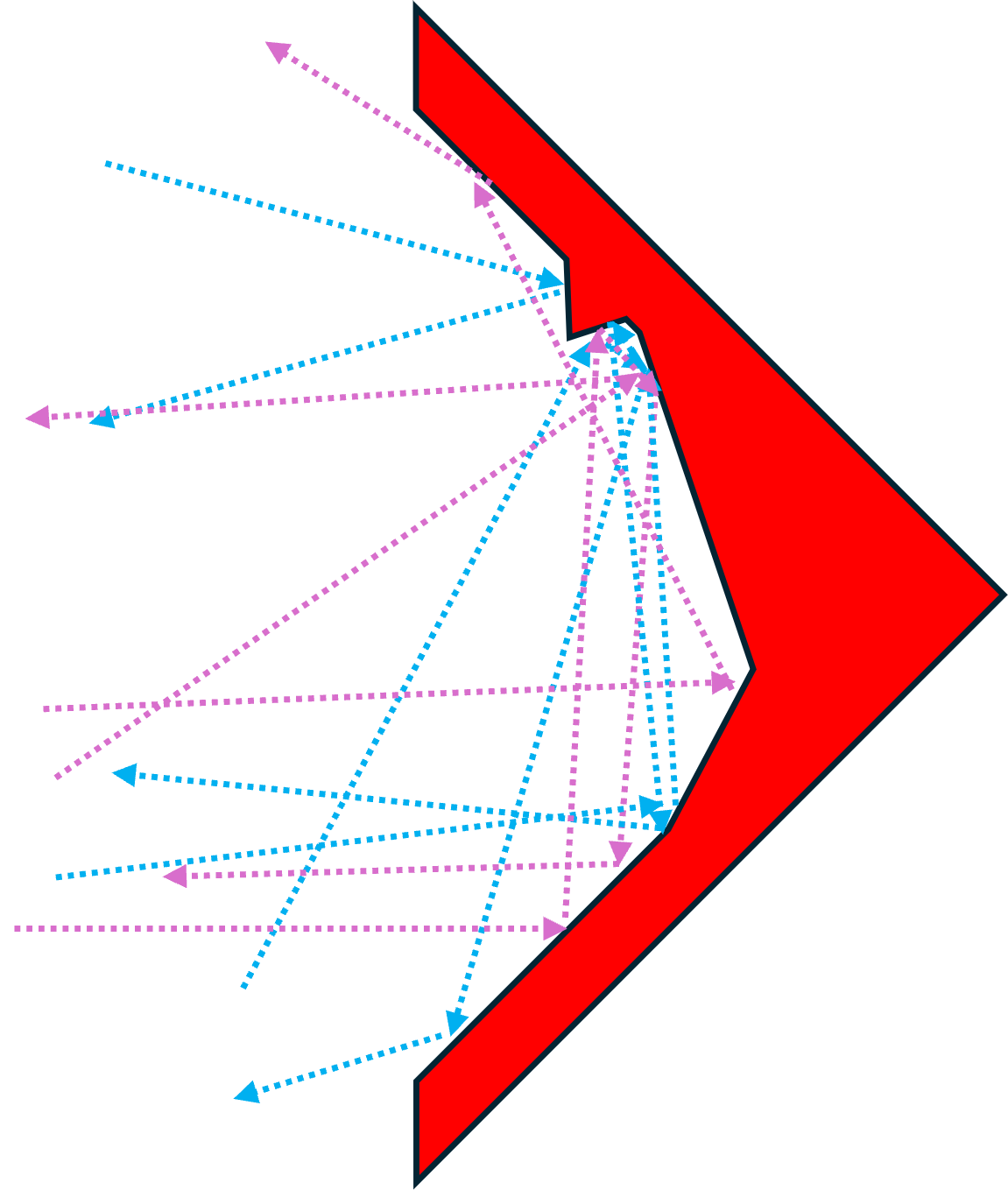

Demodulation bezeichnet also den Prozess, durch den eine hohe Frequenz in eine niedrigere Frequenz umgewandelt wird. Dies passiert beispielsweise durch eine Überlagerung von mehreren Frequenzen, die in Phase sind (gleiche Auslenkung bzw. Richtung). Handelt es sich um Wellen mit der gleichen oder annähernd gleichen Frequenz, so addieren oder subtrahieren sich ihre Amplituden (Signalstärke). Liegen beide Wellenberge oder beide Wellentäler übereinander, so verstärkt sich die Amplitude (wird lauter) und man spricht von konstruktiver Interferenz. Wird hingegen ein Wellenberg von einem Wellental überlagert (gegenphasig), löscht sich das Signal aus. Ein allgemeines Abschwächen der Signalstärke wird destruktive Interferenz genannt.

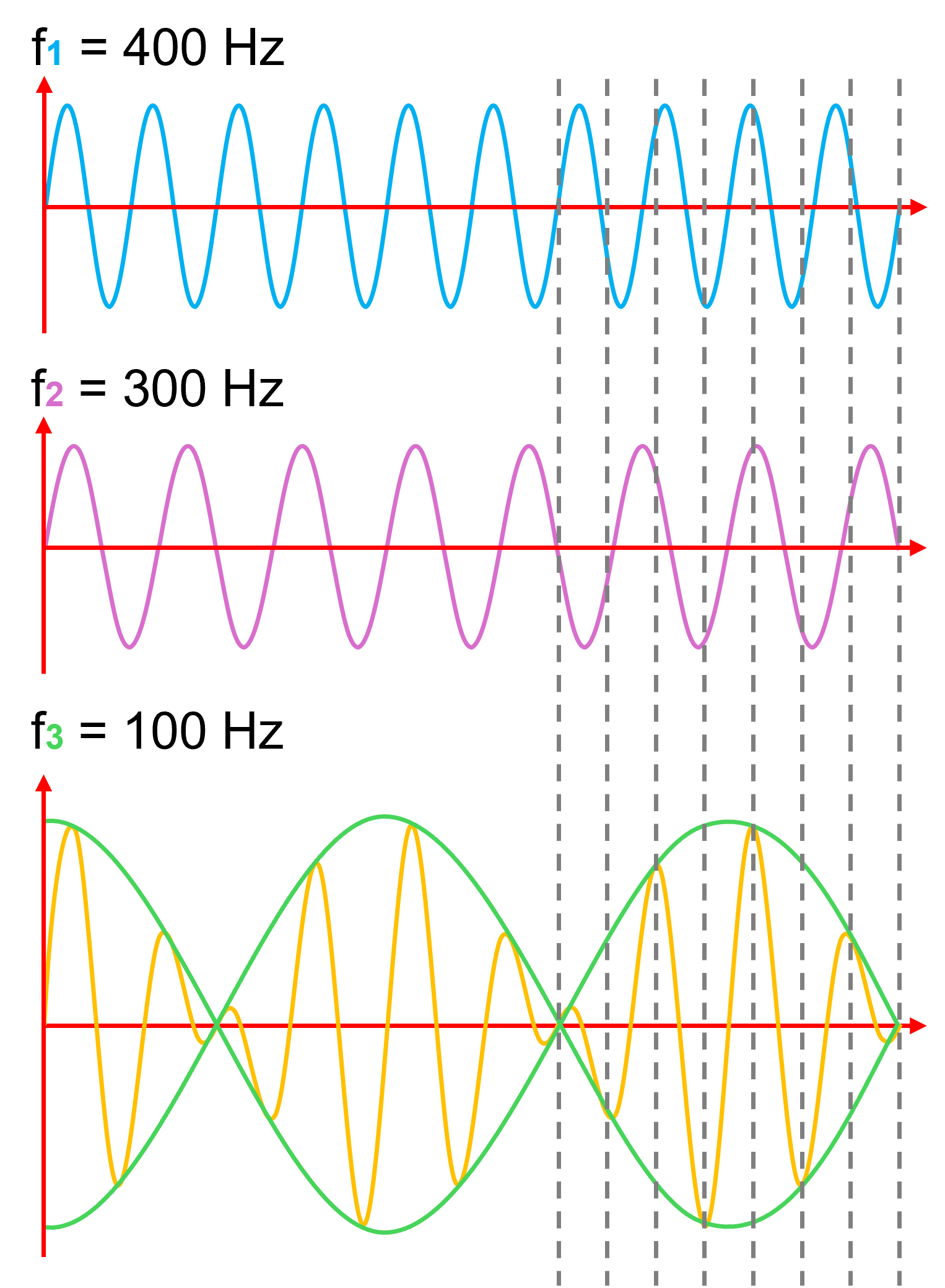

Bei unterschiedlichen Frequenzen kommt es zu einem sogenannten Schwebungseffekt. Diese Schwebungen sind das Ergebnis der sich abwechselnden konstruktiven und destruktiven Interferenz mehrerer Frequenzen (siehe Abbildung 3a, 3b). Die daraus resultierende Frequenz kann ganz einfach berechnet werden, indem die niedrigere Frequenz von der höheren subtrahiert wird. Beträgt der Frequenzunterschied bis ca. 20 Hz (sofern die Frequenzen im hörbaren Bereich sind), so kann man eine pulsierende Schwankung hören. Darüber hinaus kann das menschliche Ohr die langsame Schwankung nicht mehr wahrnehmen und man hört zwei getrennte Töne oder nur noch einen Ton [20] [27].

Abbildung 3a:

Signalüberlagerungen durch Reflexionen (eigene Abbildung von Tim Timsen).

Abbildung 3b:

Signal- bzw. Frequenzveränderung druch Interferenzen (eigene Abbildung von Tim Timsen).

Wenn nun die Ultraschallfrequenzen an Oberflächen (Wand, Objekt) reflektiert werden, kann es zu einem nichtlinearen Verhalten kommen, bei dem Wellen mit ihrer eigenen oder einer anderen Frequenz interagieren. Diese Interaktionen, besonders bei harten Oberflächen oder speziellen Materialien, erzeugen Intermodulationsprodukte. Dieser Prozess einer unbeabsichtigten Demodulation kann somit Frequenzen erzeugen, die vom menschlichen Ohr wahrgenommen werden. Ein weiteres Phänomen tritt auf, wenn sich ein Objekt im Weg der Ultraschallwelle bewegt, wie z.B. eine Hand oder eine andere reflektierende Fläche. Die Bewegung erzeugt eine Doppler-Verschiebung (Doppler-Effekt) und kann dabei Frequenzen ins hörbare Spektrum verschieben. [20] [26].

Doppler-Effekt: Wenn sich die Quelle der Welle auf den Beobachter zubewegt, wird die Wellenlänge verkürzt und die Frequenz erscheint dem Beobachter höher. Entfernt sich die Quelle der Welle vom Beobachter, wird die Wellenlänge verlängert und die Frequenz erscheint dem Beobachter niedriger. Ein hier sehr bekanntes Beispiel ist das Martinshorn eines vorbeifahrenden Krankenwagens, welches sich je nachdem, ob sich dieser auf einen zu- oder von einem wegbewegt, unterschiedlich klingt.